Ce qui sous-tend les annonces démesurées du sommet de l'IA

Tentative succincte et partielle, de donner quelques points de repères, suite aux annonces démesurées du sommet de l’IA.

Par Benoit Petit

Il se dit beaucoup de choses sur le sommet de l’IA et les annonces de Data Centres gigantesques pleuvent.

Nous tenterons, de manière succincte et partielle dans ce post, de donner des points de repères sur l’ampleur de ces annonces et d’une partie de leurs implications probables.

Pour commencer, un Data Centre d'1 GW, c’est énorme. Pour référence, le centre de données moyen, en activité, en France, a une puissance installée tournant autour de 7,5 MW. Moins d’un 100ème donc. Les plus grands Data Centres actuellement en activité sur le territoire ne dépassent pas les 100 MW. Certains projets annonçaient déjà jusqu’à 200 MW avant le sommet de l’IA. Un DC d’1 GW est donc une annonce complètement massive.

Qu’est ce qui mène à de tels ordres de grandeur ?

D’abord, vu de l’intérieur d’un Data Centre

La densité énergétique moyenne par baie est en augmentation, comme le montre ce sondage de l’Uptime Institute.

Et pour cause:

Une baie informatique “classique” dispose d’une puissance entre 2.5 et 20 kW.

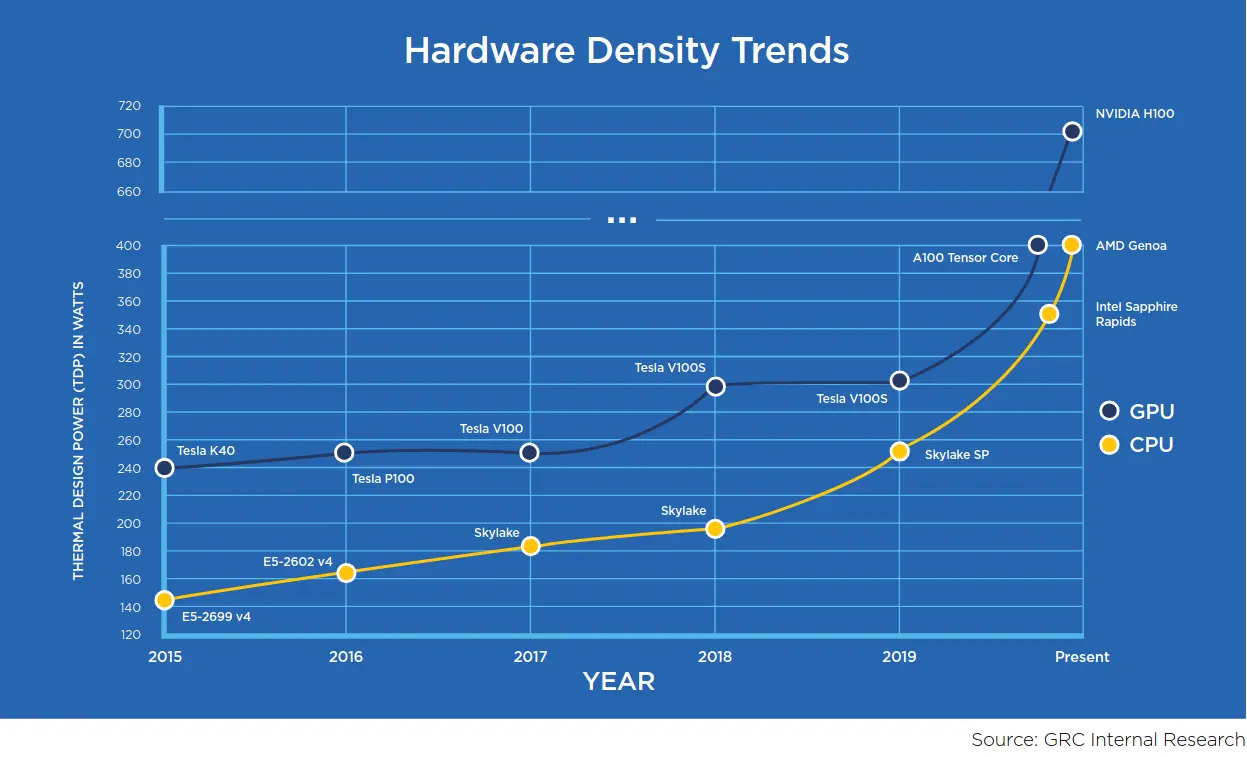

Une carte de type Nvidia H100 affiche un TDP de 700W. La puissance nécessaire environnée (+ serveur +PUE) avoisinne les 1700 W (d’après un calcul d’Epoch AI).

Les nouveaux GPU Blackwell peuvent monter à une puissance de 1200 W, non environné.

Nvidia vend aujourd’hui des baies complètes équipées pour l’IA: une baie NVL72 (composée notamment de GPUs Blackwell/GB200) affiche 120 kW de puissance nécessaire, par exemple.

On pourrait atteindre 1 MW par baie avec les futures baies annoncés !

Au delà de 40kW de puissance dans une baie, il est presque impossible de refroidir correctement avec un refroidissement par air, ou bien il faut réagencer et espacer plus les baies.

La solution privilégiée pour le HPC et l’IA générative est le DLC pour Direct Liquid Cooling, qui consiste à amener le refroidissement par eau jusqu’au contact de la machine ou directement du composant, mais ce n’est pas toujours possible. Pour les déploiements d’IA plus modestes que les baies NVidia tout équipées, le circuit de DLC peut s’arrêter à la porte de la baie, cette méthode est appellée “Door Cooling” et peut convenir jusqu’à une puissance de 70kW par baie, au delà il faut du DLC.

Ceci illustre une tendance supplémentaire aux grands Data Centres dédiés: les Data Centres plus modestes se remplissent progressivement de matériel pour l’IA. Même si c’est certainement encore une part mineure des installations aujourd’hui, elle est également à prendre en compte dans les projections de consommation énergétique futures.

Et en vue macro

Schneider Electric projette 4 scénarii d’évolution, pour la consommation d’électricité de l’IA exclusivement (hors autres usages en Data Centre):

- Business As Usual: on atteindrait 1370 TWh/an d’électricité consommée exclusivement pour l’IA en 2035. C’est ~2.5 x la consommation actuelle de tous les DC dans le monde en 2024

- Sustainable AI: 785 TWh/an

- Limits to growth: 570 TWh/an

- Electricity Crunch (saturation des grilles électriques, scénario déjà envisageable dans certains états US): 190 TWh/an

Pour revenir aux annonces de ces derniers jours, que voudraient dire l’installation de 3 Data Centres de 1GW chacun, en France ?

- La puissance installée actuelle des DC français avoisine les 2.5 GW, pour plus de 320 datacenters

- Ajouter 3GW voudrait dire plus que doubler cette capacité, tout simplement

- Bien sûr, ces déploiements, s’ils ont lieu dans les ordres de grandeur annoncés, suivront plusieurs phases, comme de coutûme dans le monde des centres de données, un puissance d'1GW ne sera pas demandée d’un seul bloc à RTE. Mais la capacité cible pose de nombreuses questions.

Ajouter 1GW n’est à priori pas neutre pour un réseau électrique, la grille risque de devoir changer, au moins localement (elle pourrait ne plus être si bas carbone qu’avant).

Illustration de cette tendance, les investissements vers les SMR (petits réacteurs nucléaires) explosent. Si l’énergie qui en sort serait peu carbonée, les conditions de leur implantation posent de nombreuses questions (beaucoup de Datacenters sont proches de zones d’habitation).

Pire : des centrales à gaz, décorellées du réseau électrique commun, commencent à apparaître, sous couvert d’annonces totalement greenwashing (“natural gas”, “green”).

Et la consommation d’eau ?

En france, pas de tours d’évaporation (réglementation sur la légionelose), mais les données sur la consommation d’eau restent difficiles à obtenir (refroidissement adiabatique, vidange ou traitement chimique de l’eau en circuit fermé). Les données disponibles sont d’ailleurs souvent difficiles à traiter, car elles mélangent eau prélevée et eau consommée.

Ce qu’il faut retenir, c’est que tout mode de refroidissement a ses limites. Un meilleur PUE peut vouloir dire un moins bon WUE. Moins d’énergie, plus d’eau.

Quelques ordres de grandeur sur les Gaz à Effet de Serre

- Google: +50% d’émissions annuelles, en 5 ans

- Microsoft: +30% l’année dernière, principalement du au béton des nouveaux Data Centres

- The Guardian estime que 662% des emisssions à l’usage (Scope 2) des Data Centres des GAFAM, sont cachées grâce aux émissions dîtes market based (utilisation comptable de certificats de garantie d’origine de l’électricité, pour soustraire une partie des émissions pourtant réellement émises, dans le bilan carbone)

Des modèles plus efficients: une solution ?

Deepseek ?

- Un article de Semi Analysis explique comment cette efficience a été mise en récit, loin de la réalité du développement de la plateforme.

- De plus, une enquête de DipLab montre que l’entrainement du modèle R1 a nécessité l’exploitation de millions de personnes.

- Même si cette efficience était réelle, l’effet rebond en annulerait probablement les effets positifs. ASML, entreprise hégémonique qui fabrique les machines capables de graver nos puces (nos “chips”), explique que les bas coûts de DeepSeek, sont bons pour le business : plus d’application de l’IA, plus de puces.

Du matériel plus efficient ?

Les courbes généralement mises en avant concernant l’efficience, présentent une efficience par unité de calcul, par FLOP par exemple, ce qui ne reflète pas l’évolution de la consommation globale des nouveaux GPU dans leur ensemble.

Or, la consommation par GPU augmente de génération en génération, comme évoqué au début de cet article et dans l’étude GRC sur le refroidissement des futures puces à 1MW.

C’est comparable à ce qui est constaté dans le monde de l’automobile: on parcours plus de Km avec 1L d’essence du fait d’une meilleure efficience des nouveaux modèles, mais on augmente le poids de la voiture donc la consommation aussi, donc le réservoir. Le paradoxe de Jevons est bien là.

Il y a beaucoup plus à dire

Tous ces aspects et d’autres seront traités dans l’étude ADEME sur les consommations des Data Centres qui est en cours, réalisée avec studio dégel (Cécile Diguet) et Lorraine de Montenay (Omnicité et association GreenIT).

Sources

- The Future of Immersion Cooling: The Path to Cooling 1000W Chips, and Beyond!, GRC, 2023

- Artificial Intelligence and Electricity, Schneider Electric, 2024

- GB200 Hardware Architecture – Component Supply Chain & BOM, Semi Analysis, 2024

- Data center emissions probably 662% higher than big tech claims. Can it keep up the ruse?, The Guardian, 2024

- Microsoft’s AI Push Imperils Climate Goal as Carbon Emissions Jump 30%, Data Centre Knowledge, 2024

- Google reports 50 per cent jump in emissions due to AI energy use, Dezeen, 2024

- Fluidstack va construire un supercalculateur d’IA de 1 GW en France, 10 milliards €

- France and UAE to invest billions into 1GW European AI data center

- Brookfield and Data4 to spend €20bn on AI infrastructure in France